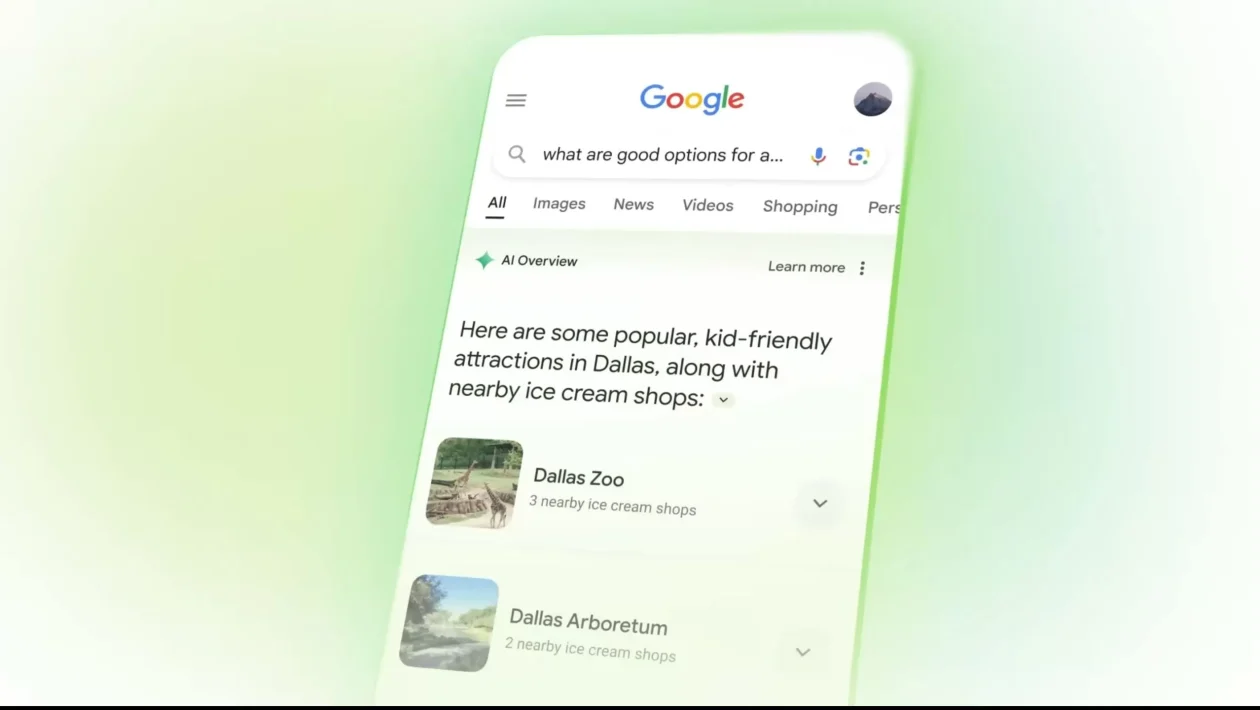

Googles sökmotor är inte längre bara en sökmotor. Sedan Google började integrera funktionen ”AI Overviews” är den också en chatbot med artificiell intelligens som svarar på användarnas frågor utan att de behöver klicka på någon länk. Problemet är att den underliggande tekniken, de stora språkmodellerna, fungerar probabilistiskt, vilket innebär att de tenderar att hitta på svar när de inte är helt säkra på hur de ska svara.

En trovärdig lögn. Den här gången kan ett påhittat svar från AI Overviews leda till att Google hamnar i skottgluggen. Käranden är Wolf River Electric, ett solenergiföretag i Minnesota. Och orsaken till tvisten är, med all rätt, en stämning som aldrig har existerat.

Enligt energiföretagets advokater ledde sökningen på termerna ”stämning mot Wolf River Electric” på Google till att AI svarade med förtal. De citerar ett fall där AI Overviews svarade att Wolf River Electric hade stämts av Minnesotas justitieminister för ”vilseledande försäljningsmetoder”, såsom att ljuga för kunderna om hur mycket de kommer att spara och lura ägarna att skriva på kontrakt med dolda avgifter.

AI presenterade fallet med fullständig övertygelse och nämnde fyra av företagets chefer vid namn: Justin Nielsen, Vladimir Marchenko, Luka Bozek och Jonathan Latcham, och visade till och med ett foto av Nielsen tillsammans med de falska anklagelserna. För att stödja sina påståenden citerade AI fyra länkar: tre nyhetsartiklar och ett uttalande från justitieministern. Ingen av länkarna nämnde dock någon stämning mot Wolf River Electric.

Det är inte första gången. Denna typ av fel kallas ”hallucination” och är mycket vanligt i språkmodeller på grund av hur de väver ihop sitt svar genom att förutsäga följande ord, ibland dra med sig det ursprungliga felet tills det blir en trovärdig lögn med alla möjliga påhittade förgreningar, som i leken med trasig telefon.

När Google började integrera AI Overview i sökmotorn var man tvungen att ta bort det från vissa sökningar, särskilt recept och näringsinformation, eftersom det rekommenderade att man skulle lägga lim på pizzan eller äta en sten om dagen för att hålla sig frisk.

Ett svar per fråga. Wolf River Electric hävdar att flera kunder har sagt upp sina kontrakt, värda upp till 150 000 dollar, på grund av vad de läst i AI Overviews. Problemet är att svaren i AI Overviews är personanpassade: de härleds i stunden, så de kan variera från en fråga till en annan.

Det oroar inte Wolf River Electrics advokater, eftersom de vet att det kan hända igen. ”Den här stämningen handlar inte bara om att försvara vårt företags rykte, utan om att försvara rättvisa, sanning och ansvar i den artificiella intelligensens era”, säger Nicholas Kasprowicz, företagets juridiska rådgivare.

David mot Goliat. Fallet väcktes i mars i en delstatsdomstol och har just överklagats till en federal domstol i USA. Det kan komma att skapa prejudikat för huruvida ett teknikföretag ska hållas ansvarigt för att dess AI genererar och sprider desinformation. Svaret på denna fråga kan bli en vändpunkt för AI-företag, som länge har försökt undvika ansvar för resultaten av sina språkmodeller.

Google har i sitt försvar beskrivit incidenten som ett ofarligt misstag. ”De allra flesta av våra AI Overviews är korrekta och användbara, men som med all ny teknik kan fel uppstå”, förklarade en talesperson för företaget. Google säger att man agerade snabbt för att lösa problemet så snart man blev medveten om det, i linje med sina senaste ansträngningar för att låta användare korrigera fel i AI.